阿里云消息队列RocketMQ版

阿里云消息产品全景

阿里云消息产品全景

产品架构

产品架构

RocketMQ 诞生于阿里内部核心电商系统,主要为业务系统提供异步化、低延迟、业务解耦、削峰填谷、异构数据复制的能力。核心价值主打:功能多样,高性能,高可靠容灾,可观测运维,帮助业务系统完成高价值数据传输和驱动。

多功能消息类型:顺序消息——解决CDC增量同步、顺序交易撮合难题

多功能消息类型:顺序消息——解决CDC增量同步、顺序交易撮合难题

特性介绍:通过分区顺序传输能力支持传统严格顺序CDC数据同步以及交易撮合等场景

多功能消息类型:精准定时消息——解决分布式定时调度难题

多功能消息类型:精准定时消息——解决分布式定时调度难题

特性介绍:无需借助外部依赖即可实现分布式秒级精度定时消息通知,解决传统数据库扫表定时等方案的低效不可扩展问题。

多功能消息类型:精准定时消息——解决分布式定时调度难题

多功能消息类型:精准定时消息——解决分布式定时调度难题

特性介绍:无需借助外部依赖即可实现分布式秒级精度定时消息通知,解决传统数据库扫表定时等方案的低效不可扩展问题。

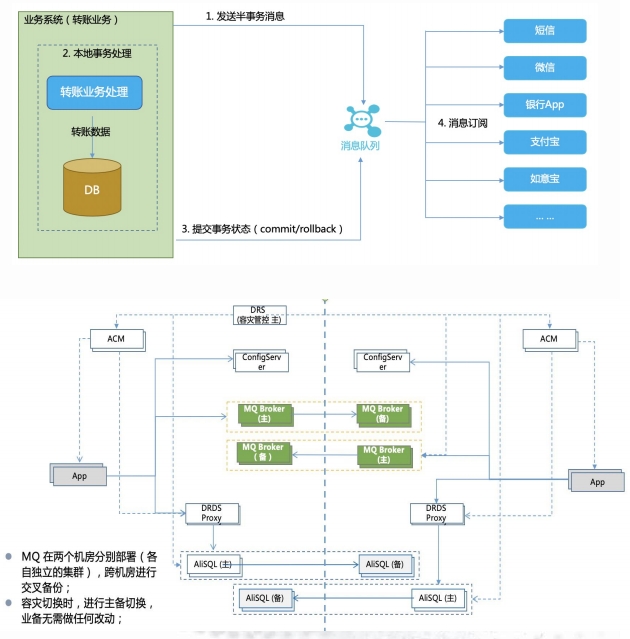

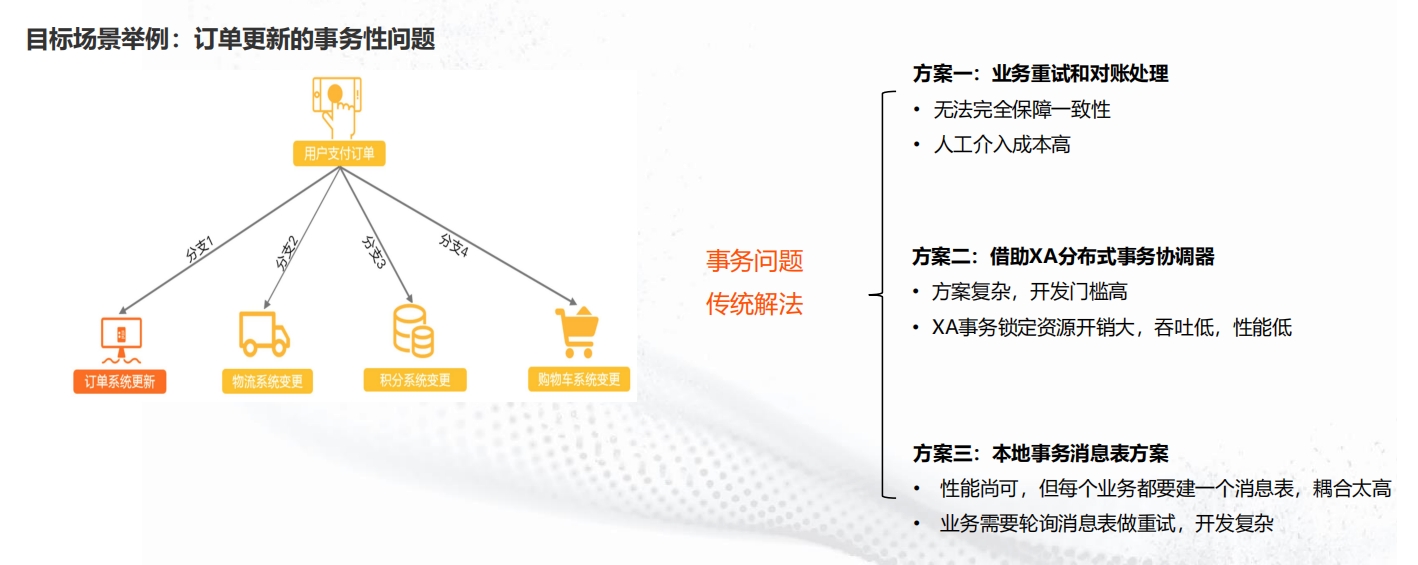

多功能消息类型:事务消息——解决分布式事务一致性难题

多功能消息类型:事务消息——解决分布式事务一致性难题

特性介绍:提供高吞吐、可扩展性能的分布式事务协调保障,解决传统XA事务无法突破的高性能问题。问题描述:如何保证核心业务(订单支付)和多个下游业务的执行结果完全一致,同时成功或者同时失败。特征拆解:问题有一个主分支,同时有若干个下游场景需要与之一致;该事务的处理耦合业务逻辑(数据库等操作)

多功能消息类型:事务消息——解决分布式事务一致性难题

多功能消息类型:事务消息——解决分布式事务一致性难题

特性介绍:提供高吞吐、可扩展性能的分布式事务协调保障,解决传统XA事务无法突破的高性能问题。

多功能消息过滤:TAG/SQL过滤——高效率解决消费过滤问题

多功能消息过滤:TAG/SQL过滤——高效率解决消费过滤问题

特性介绍:提供TAG和SQL92两种过滤能力,支持服务端高效过滤自定义消息子集,避免流量传输浪费和客户端压力。

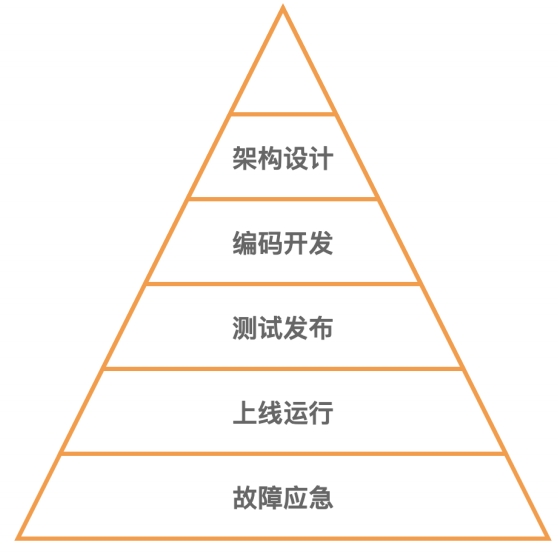

稳定性:消息队列全生命周期稳定性建设

稳定性:消息队列全生命周期稳定性建设

稳定性:架构设计——高并发写毛刺优化

稳定性:架构设计——高并发写毛刺优化

稳定性:架构设计——存储碎片整理,优化堆积冷读性能

稳定性:架构设计——存储碎片整理,优化堆积冷读性能

稳定性:架构设计——局部节点故障隔离

稳定性:架构设计——局部节点故障隔离

生产环境局部节点宕机故障不可避免,系统架构在设计上能够及时隔离故障节点,降低局部异常的影响对业务非常重要

稳定性:系统可观测——360自动化巡检

稳定性:系统可观测——360自动化巡检

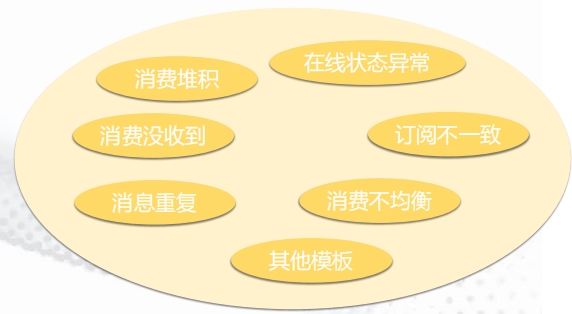

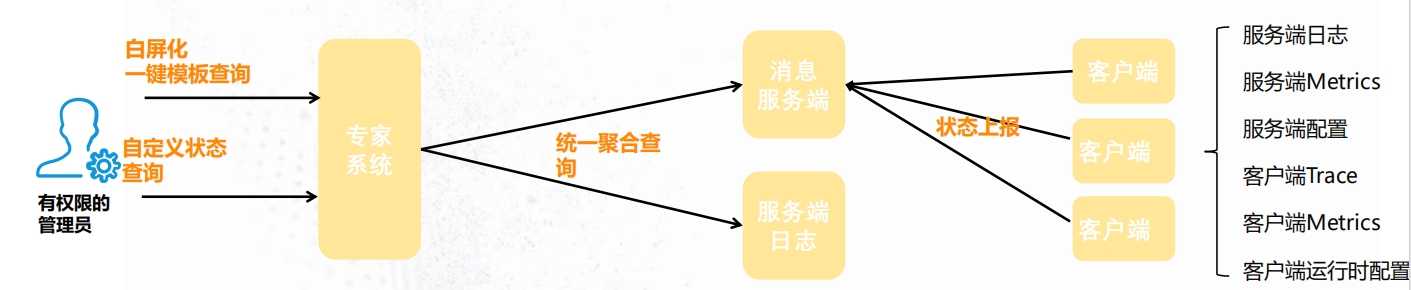

稳定性:专家系统——快速定位问题利器

稳定性:专家系统——快速定位问题利器

MQ耦合业务逻辑,生产环境故障问题需要收集大量信息才能做判断,专家经验至关重要,以产品化能力沉淀专家系统,支持快速定位问题

稳定性:专家系统操作演示视频

稳定性:专家系统操作演示视频

容灾体系:消息队列容灾体系分级

容灾体系:消息队列容灾体系分级

更易用:实时扩缩容——解决自建消息扩容慢、缩容困难痛点

更易用:实时扩缩容——解决自建消息扩容慢、缩容困难痛点

消息系统容量保障是核心链路生命线,容量过剩是浪费,容量不足系统挂掉,扩缩容效率和稳定性至关重要

更易用:多接入点——解决线下IDC访问、混合组网问题

更易用:多接入点——解决线下IDC访问、混合组网问题

一个实例(集群)同时支持VPC内网、公网、线下IDC、多VPC访问,兼顾安全和成本

更易用:收发流量隔离约束——读写分离控制提高集群稳定性

更易用:收发流量隔离约束——读写分离控制提高集群稳定性

读写TPS自定义比例量化隔离约束,以明确SLA确保收发相互不影响,提高集群稳定性

更易用:客户端动态配置管理——故障降级止血利器

更易用:客户端动态配置管理——故障降级止血利器

通过客户端配置动态下发更新机制,实现消费顺序性、重试策略等重要参数的动态更新,在故障降级和止血场景速度更快、不易出错

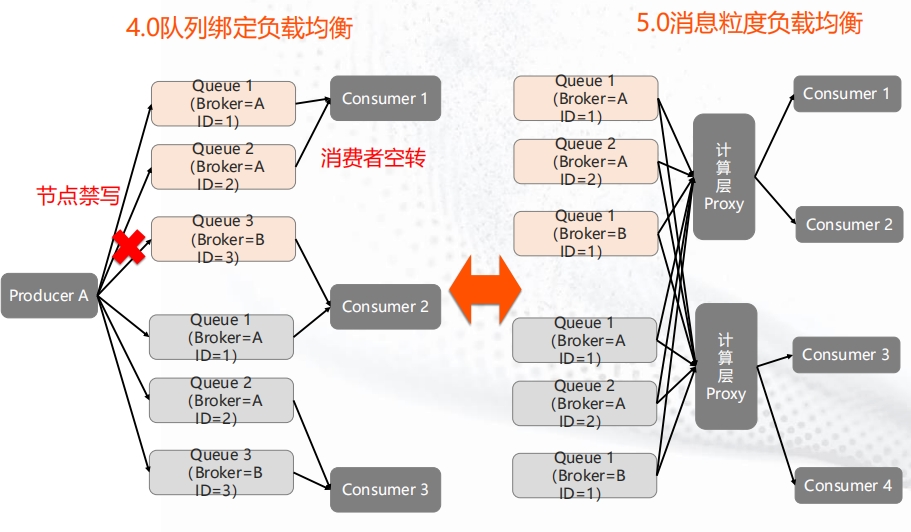

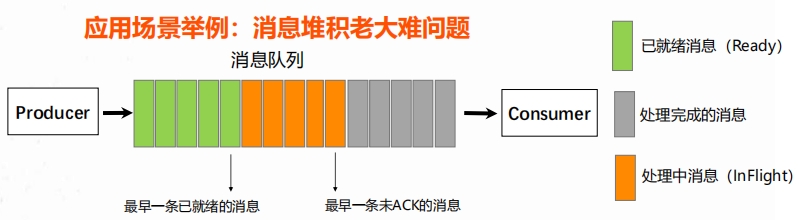

更易用:轻量客户端——彻底解决消费不均衡堆积痛点

更易用:轻量客户端——彻底解决消费不均衡堆积痛点

RocketMQ 5.0客户端轻量化设计,负载均衡收敛到服务端,支持消息粒度负载均衡,队列数量和客户端不再有绑定和关联。

更易用:多语言客户端——解决多语言能力不对齐历史问题

更易用:多语言客户端——解决多语言能力不对齐历史问题

RocketMQ 5.0基于gRPC协议以及轻量化设计,可以快速补齐java/C++/.NET/Go等主流SDK能力,提供稳定可靠的版本。

更易用:便捷消息查询——快速排查消息收发问题

更易用:便捷消息查询——快速排查消息收发问题

大规模弹性:突发流量自适应弹性——兜底业务不确定性风险

大规模弹性:突发流量自适应弹性——兜底业务不确定性风险

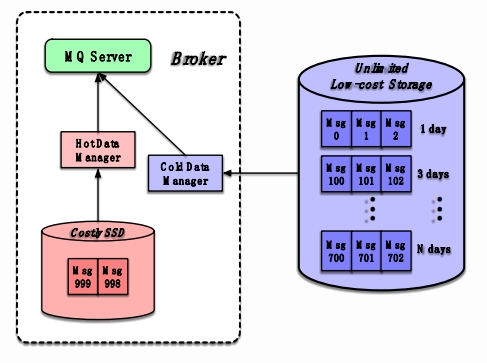

大规模弹性:存储Serverless——解决大容量低成本按需存储

大规模弹性:存储Serverless——解决大容量低成本按需存储

消息可观测:点、线、面解决线上收发问题排查痛点

消息可观测:点、线、面解决线上收发问题排查痛点

消息链路耦合业务系统,复杂带状态,问题排查需要强大的可观测系统和经验做支撑才能提高运维效率。生产者、消费者多对多:业务调用链路网状结构,上下游梳理困难。上下游解耦、异步链路:异步化调用,信息收集不完整。消息是状态数据:未消费成功、定时中等状态增加排查的复杂度。消费链路耦合复杂的业务处理逻辑:无法快速定位问题边界。

消息可观测:仪表盘功能

消息可观测:仪表盘功能

消息可观测:消息轨迹功能

消息可观测:消息轨迹功能

产品集成组合

产品集成组合

RocketMQ5.0提供主流云产品集成,开箱即用,免开发。统一基于阿里云事件中心,提供高可用和Serverless弹性能力,免运维。

竞争分析:对比开源自建优势

竞争分析:对比开源自建优势

钉钉——定时消息实现已读用户功能

钉钉——定时消息实现已读用户功能

钉钉(Ding Talk)是阿里巴巴集团打造的企业级智能移动办公平台,引领未来新一代工作方式,将陪伴每一个企业成长,是数字经济时代的企业组织协同办公和应用开发平台,是新生产力工具。

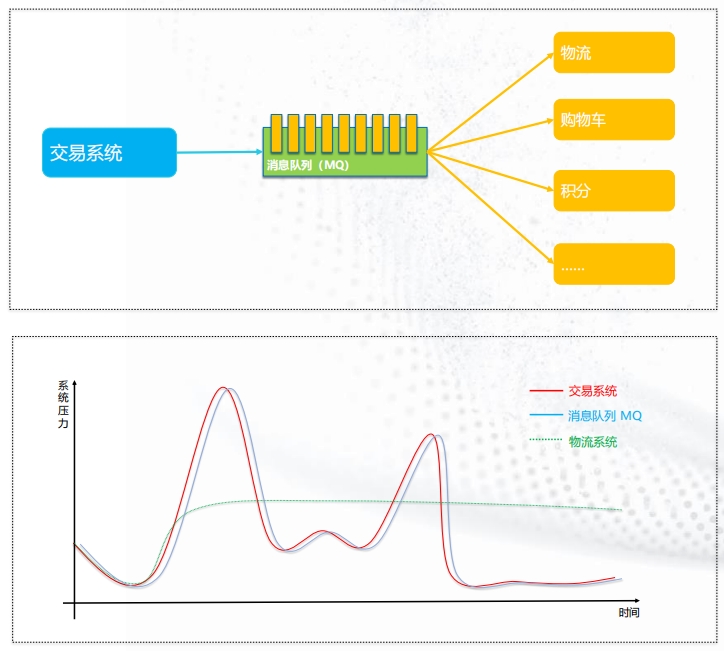

典型场景:在线交易 - 应用解耦 + 削峰填谷

典型场景:在线交易 - 应用解耦 + 削峰填谷

客户案例:银行交易系统

客户案例:银行交易系统

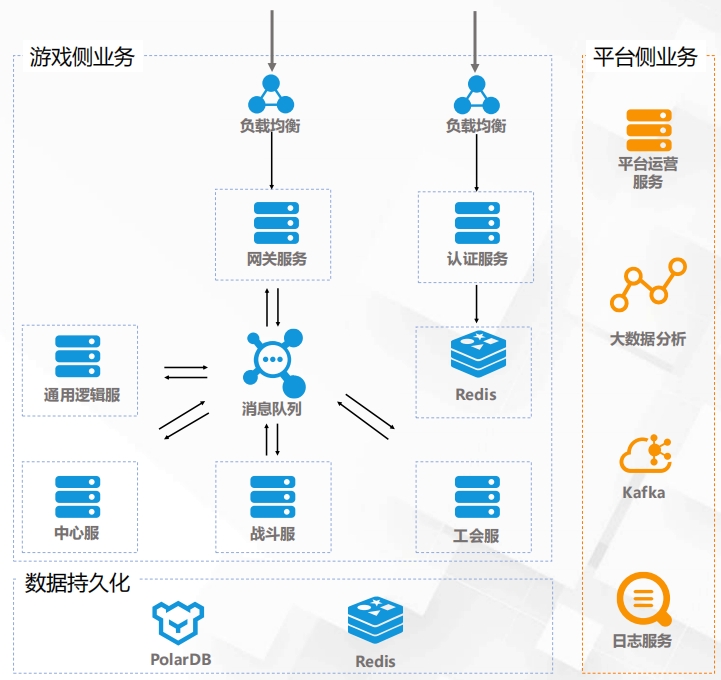

客户案例:XX游戏

客户案例:XX游戏

产品推荐

首页

首页