腾讯云qGPU容器

立即咨询

GPU当前现状

GPU当前现状

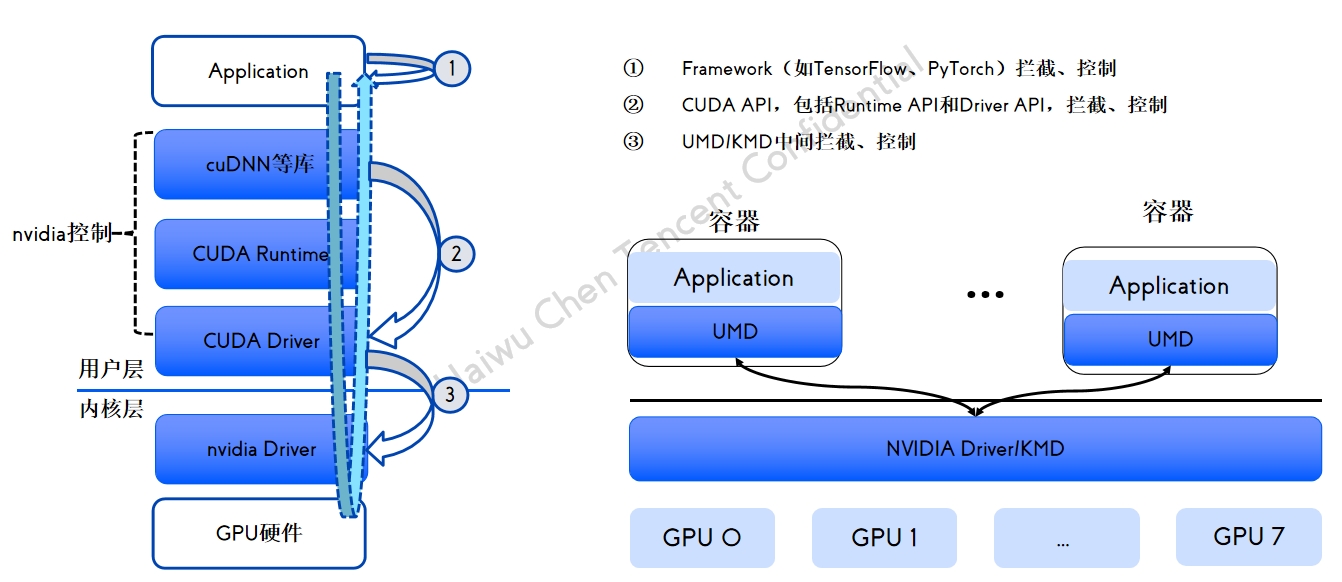

GPU 共享方案拦截分析

GPU 共享方案拦截分析

qGPU 容器产品介绍

qGPU 容器产品介绍

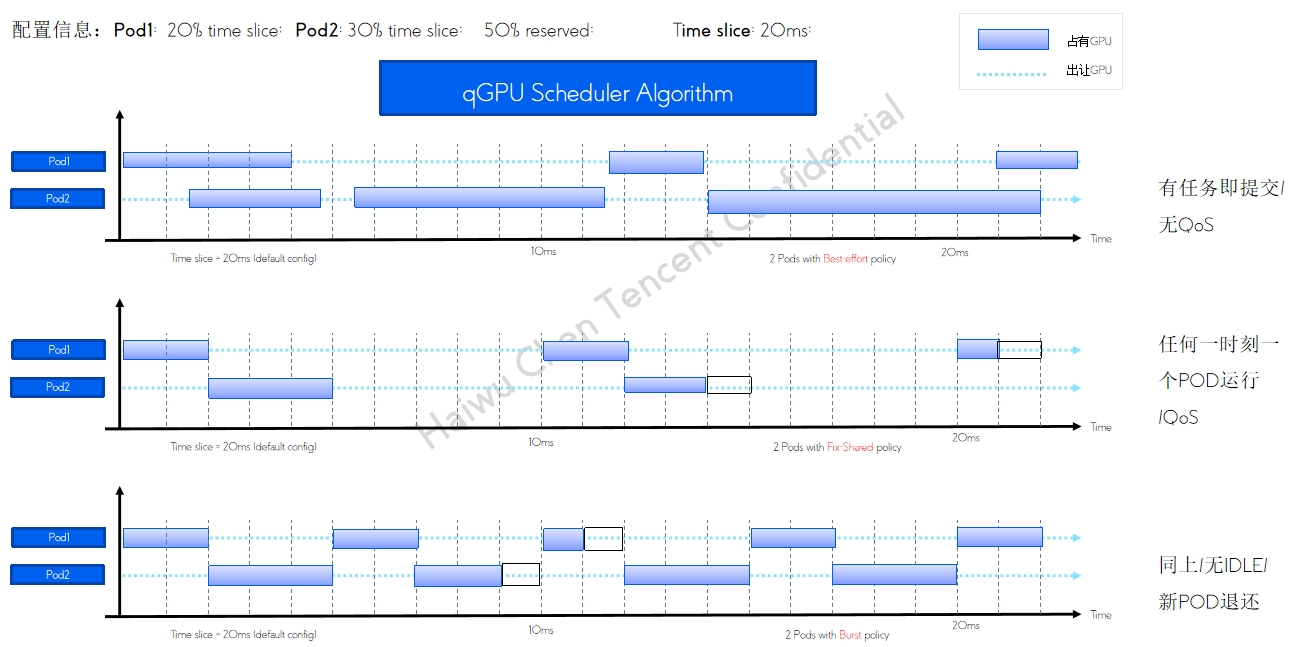

qGPU调度策略

qGPU调度策略

qGPU 单卡调度policy

qGPU 单卡调度policy

qGPU 在离线混部及调度方式

qGPU 在离线混部及调度方式

高优任务 平均分配 保证负载均衡 低优任务 尽量填满 保证资源利用率 支持在线 100% 抢占 GPU利用率的极致提高 业内唯一GPU在离线混部技术

支持主流OS版本

支持主流OS版本

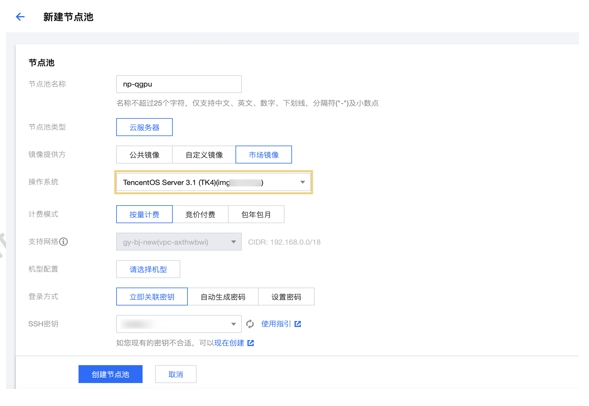

qGPU交付方式

qGPU交付方式

qGPU IDC交付件

qGPU IDC交付件

公有云使用qGPU

公有云使用qGPU

qGPU监控组件elastic-gpu-exporter

qGPU监控组件elastic-gpu-exporter

使用限制

使用限制

案例一:某头部互联网企业OCR场景

案例一:某头部互联网企业OCR场景

案例二:某在线教育AI推理业务

案例二:某在线教育AI推理业务

产品推荐

天清汉马USG数据防泄露系统(DLP),从敏感信息内容、敏感信息的拥有者、对敏感信息的操作行为三个角度对数据进行分析,通过清晰直观的视图,让管理者及时了解企业内部的敏感信息使用情况。

敏捷数据管理平台软件(ADM)是上海上讯信息技术股份有限公司(以下简称“上讯信息”)自主研发的,主要面向金融、运营商、政府、能源、医疗等行业打造的全生命周期数据安全管理软件产品,用于数据备份、备份数据恢复验证、测试数据交付和静态数据脱敏等应用场景,可为企业上、中、下游数据的高效使用和安全管控提供一套整体解决方案。

追一科技的智能语音机器人Call基于自然语言处理NLP、语音识别ASR和语音合成TTS技术,实现自动电话外呼和应答,用自然逼真的对话与客户沟通,帮助企业提高外呼效率和标准化外呼流程,实现外呼数据智能化管理。

首页

首页